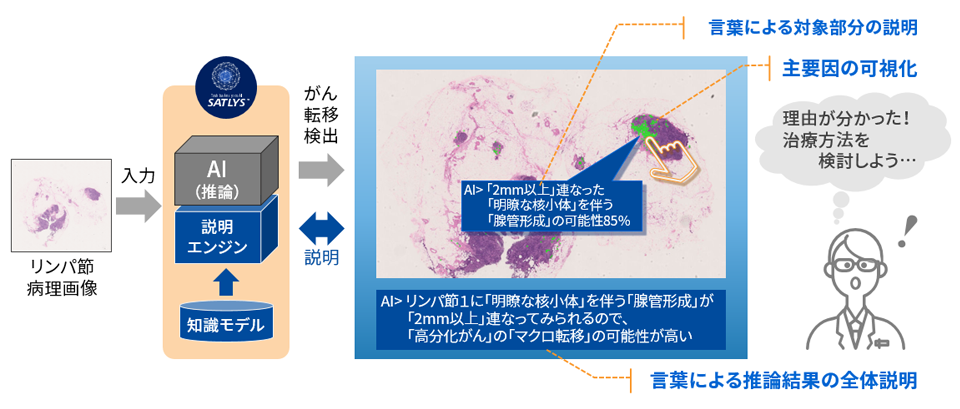

視覚と言語による説明技術で、AIの推論結果に対する人の理解を向上

第3次AIブームの背景にあるディープラーニングの技術は、数十以上の中間層をもった多層の人工ニューラルネットワークの学習を可能にする機械学習手法です。ディープラーニングを用いた画像認識等では、人の識別能力を超えるものも登場しています。この手法は、入力した学習データとその出力結果からのフィードバックで学習を行うエンドツーエンド型であるため、特徴量設計をしなくて済むというメリットがある反面、学習されたネットワークによる情報処理がブラックボックスであるため推論結果が得られた理由が分かり辛いというデメリットがあります。そのため、説明可能なAIが求められています。

説明の目的と内容は、ユースケースによって様々ですが、特に、誤った判断が重大な影響を及ぼすミッションクリティカルな分野では、人がAIの推論結果を基に最終判断を行うため、人が理解できる説明技術が重要です。また、推論結果の説明技術も多岐に亘っていますが、これまでの説明技術は、推論結果の利用者が容易に理解できるとは限りませんでした。例えば、これまでの技術として、ディープラーニングの学習済みモデルが推論結果に影響を与えた画像データの箇所を特定し、推論結果の根拠を視覚的に説明する手法があります。しかし、より詳細な情報を得るには、言語による説明が必要になってきます。つまり、推論結果の利用者が、結果の根拠を十分に理解するためには、視覚と言語による説明が有効と考えています。

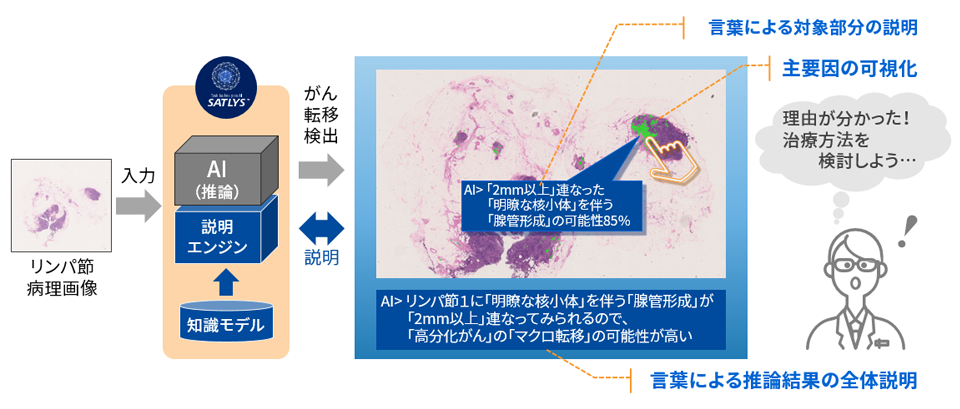

図1は、病理医を支援する病理画像解析AIのシステム構成例および表示イメージです。表示イメージでは、がんのリンパ節転移の有無を推論した結果を緑色のドットで視覚的に示し、また、その箇所を指定することで、詳細情報を言語で示します。これにより、その部分に対する推論結果の根拠がより分かりやすくなります。さらに、全体的な推論の理由を下部に表示することで、理解を高めることができます。

図1において、説明エンジンは、AI推論部分とともに視覚と言語による部分的な説明を生成し、また、知識モデルを用いて全体的な説明を生成します。これらの視覚と言語による説明を生成するためには、学習データに正解ラベルだけでなく詳細情報を与える必要がありますが、より多くの熟練者の知見をAIモデルに活かすことが可能となります。視覚と言語による説明可能なAIの実現に向けて、部分説明機能を持つディープラーニングモデルの設計、詳細データを与えるための学習データの準備および知識モデルの構築などの研究開発を進めています。

当社は、特にディープラーニングを用いたAIの社会実装に貢献することを目指して、説明可能なAIの技術開発に取り組んでいます。

説明可能なAIの例

AIモデルが異常と判断した箇所が緑色で表示され、全体的な説明が画面の下に表示される。異常個所を選択すると、言語で詳細情報が表示される。AIモデルの推論の理由が視覚と言葉で理解でき、意思決定に必要な根拠が得られる。

- [1] 推論根拠を提示し人の判断を支援する東芝アナリティクスAI“ SATLYS ”の適用(東芝レビュー) (株式会社東芝)